Capacités clés

Détectez et atténuez les bots et les agents LLM qui scrapent votre contenu, vos prix et vos données – assurant ainsi la sécurité de votre contenu et le contrôle de votre entreprise.

Pré-filtrez les bots avant qu'ils n'atteignent votre site

Bloquez les bots de scraping

dès la première requête

, avant qu’ils ne puissent accéder à une seule page. Un défi invisible élimine les bots à la périphérie, sans interaction requise de l’utilisateur final.

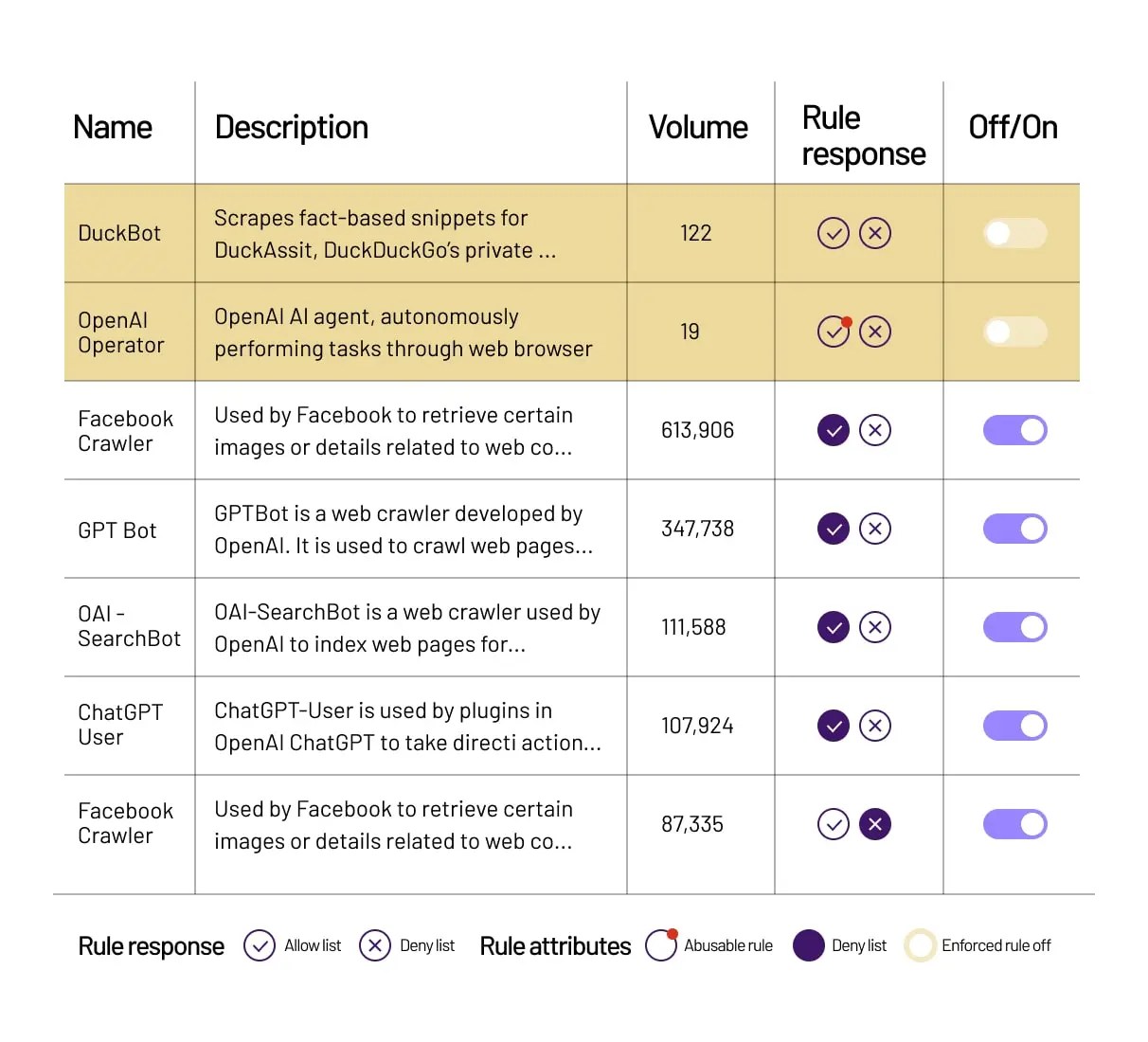

Surveillez et contrôlez les bots connus et les scrapers LLM

Obtenez de la visibilité sur

les scrapers LLM

et l’activité des bots connus. Choisissez d’autoriser, de refuser, de

monétiser

, de supprimer les publicités ou d’afficher un contenu alternatif.

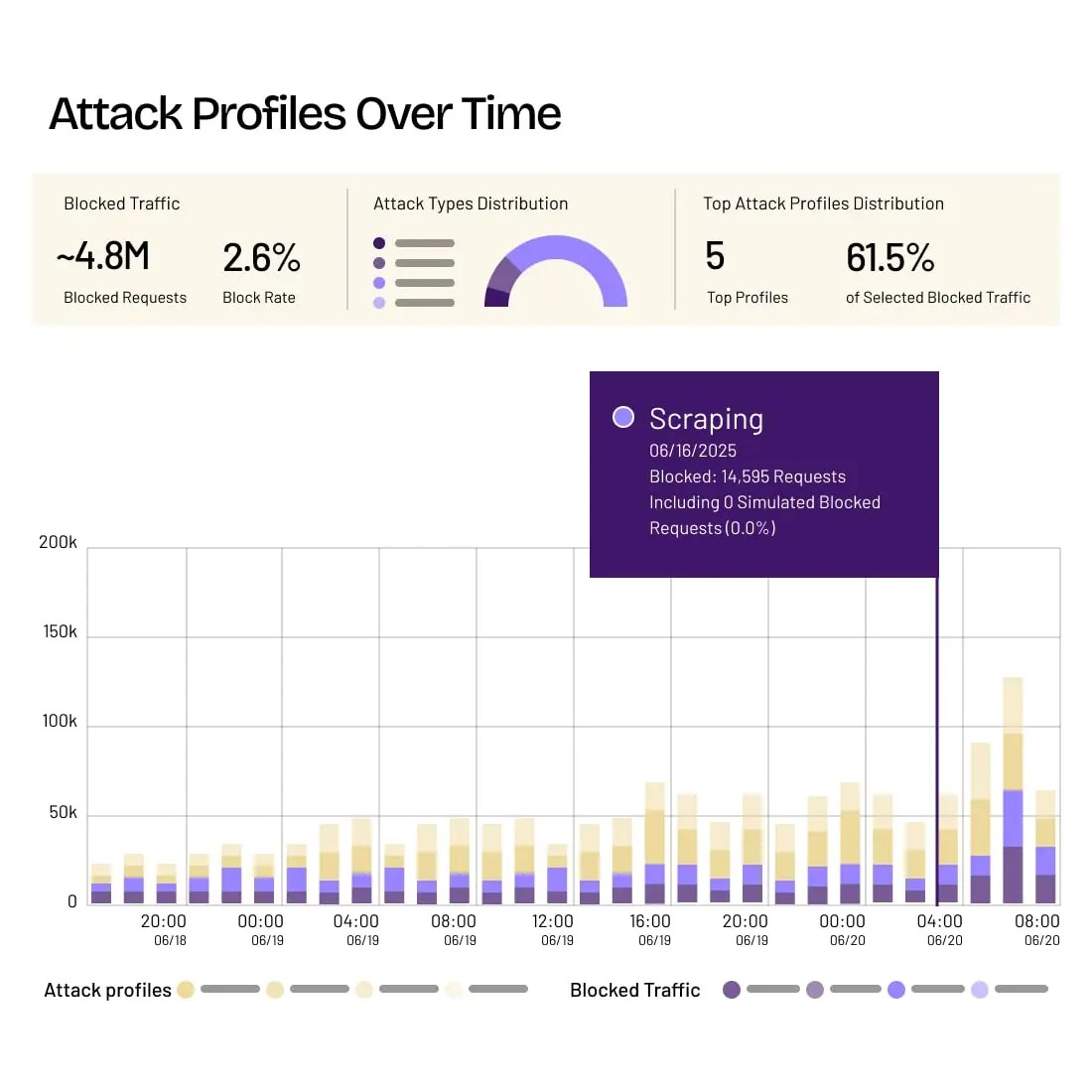

Obtenez des informations détaillées sur l'activité de scraping

Définissez les priorités des menaces et réagissez rapidement aux risques évolutifs.

Identifiez les chemins d’attaque des bots

et les comportements changeants, et obtenez une clarté détaillée sur les actions et les intentions des attaquants.

Protéger les clients contre les risques en évolution

HUMAN est reconnu par des organisations mondiales dans tous les secteurs pour protéger contre le scraping par des bots sophistiqués et des agents LLM.

Renseignement sur les menaces :

L'élément HUMAN

L’équipe de recherche et de renseignement sur les menaces Satori découvre, analyse et perturbe les cybermenaces et les schémas de fraude qui sapent la confiance dans le paysage numérique, fournissant des recherches de pointe qui renforcent la protection des clients et contrecarrent les acteurs malveillants pour un internet plus sûr.

Explorer Satori

Arrêtez le scraping avec HUMAN

Protégez-vous contre le scraping de contenu, de prix et de données par des bots sophistiqués et des agents LLM avec HUMAN Sightline.

En savoir plus

FAQ

Qu'est-ce que le web scraping ?

Le web scraping

est lorsque des bots extraient automatiquement de grandes quantités de données de sites web, comme les prix, les détails des produits ou le contenu propriétaire, souvent sans autorisation. Cela peut nuire aux entreprises en donnant un avantage déloyal aux concurrents ou en surchargeant les serveurs.Comment fonctionne le web scraping ?

Le web scraping fonctionne en utilisant des bots qui visitent des pages web, extraient des données du HTML ou des API, et stockent ces informations pour une utilisation non autorisée. Ces bots peuvent imiter le comportement de navigation humaine pour éviter la détection, rendant difficile pour les mesures de sécurité de base de les repérer. Des solutions anti-scraping avancées sont essentielles pour identifier ces modèles subtils et arrêter le vol de données en temps réel.

Comment empêcher le web scraping ?

Pour empêcher le web scraping, les entreprises doivent mettre en place des défenses sophistiquées comme la technologie anti-scraping, l’analyse comportementale et des outils d’atténuation des bots. Cela inclut l’analyse des interactions des utilisateurs, la surveillance des activités inhabituelles et le blocage des requêtes suspectes avant que les données ne puissent être extraites. La protection contre le web scraping de HUMAN garantit que les informations sensibles restent sécurisées tout en maintenant l’accès pour les utilisateurs légitimes.

Comment HUMAN protège-t-il mon site contre le scraping ?

HUMAN arrête les scrapers en détectant les modèles d’automatisation que les bots ne peuvent pas cacher, comme des vitesses de navigation impossibles ou des sources de trafic inhabituelles. Notre technologie anti-scraping maintient votre site sécurisé et vos données hors de portée des mauvaises mains.

HUMAN peut-il arrêter d'autres types de bots ?

Oui. En plus des capacités anti-scraping, HUMAN défend contre une large gamme de menaces automatisées, y compris le bourrage d’identifiants, l’accaparement d’inventaire, la création de faux comptes, et la fraude publicitaire. Notre plateforme est conçue pour protéger l’ensemble du parcours numérique contre tous les types de trafic de bots malveillants.

Demander une démonstration